Apache Kafka ist ein Open-Source-System für verteiltes Echtzeit Event-Streaming, das für die Daten-Stream-Verarbeitung, Datenpipelines und die Datenintegration verwendet wird.

Hochleistungsfähige Datenpipelines, Streaming-Analysen, Datenintegration und unternehmenskritische Anwendungen sind nur einige Anwendungsfälle.

Ursprünglich 2011 bei LinkedIn entwickelt, hat sich Kafka schnell von einer reinen Messaging-Queue zu einer vollwertigen Event-Streaming-Plattform entwickelt,

Kafka wird heute bereits von mehr als 80 % der Fortune-500-Unternehmen genutzt und bietet zahlreiche Vorteile und eröffnet zahllose neue Anwendungsfälle für große und kleine Unternehmen.

Vorteile

Extreme Fehlertoleranz

Kafka speichert sich, Daten und Events, bis zu einem von dir konfigurierbaren Zeitraum.

Selbst wenn etwas schiefgeht, wie Netzwerkprobleme oder Anwendungs- und Systemausfälle, weiß Kafka automatisch, an welcher Stelle die Daten gelesen und weiterverarbeitet werden müssen, sobald die Systeme wieder verfügbar sind.

Hinzukommend können deine Anwendungen und Systeme gewartet werden, ohne, dass Daten verloren gehen.

Wenn die Systeme wieder hochfahren und online sind, werden die Daten automatisch genau an dem Punkt abgeholt, an dem das System ausgefallen ist.

Hoch verfügbar und ausfallsicher

Damit geschäftskritische Anwendungsfälle realisiert werden können, ist ein Kafka-Cluster hoch skalierbar und fehlertolerant.

Fällt einer der Server aus, übernehmen die anderen Server dessen Arbeit, um einen kontinuierlichen Betrieb ohne Datenverlust zu gewährleisten.

Standartisierte Konnektoren

Kafka bietet mit Kafka Connect ein einheitliches und standardisiertes “out-of-the-box” Connect-Interface. Dieses bietet bereits Hunderte von Konnektoren, um Daten in Echtzeit mit Event- und Datenquellen wie Datenbanken, mobilen Geräten, Cloud-Diensten und Softwareanwendungen zu verbinden.

Warum Kafka?

Wir möchten unseren Kunden die bestmögliche Lösung bereitstellen, dafür greifen wir auf bestehende Tools und Standards im Datenmanagement zurück.

Als Basis unseres Tool-Sets nutzen wir die Open Source Technologie Apache Kafka.

Kafka wird von Tausenden von Unternehmen für hochleistungsfähige Datenpipelines, Streaming-Analysen, Datenintegration und unternehmenskritische Anwendungen genutzt wird.

Kafka ist die De-facto-Technologie, die Entwickler und Architekten verwenden, um die neueste Generation skalierbarer Streaming-Anwendungen zu erstellen, die Daten in Echtzeit verarbeiten können.

Keine Eigenentwicklung und Inselwissen

Kafka stellt eine umfassende standardisierte Grundlage für Echtzeit Daten-Streaming, Datenmanagement und Konnektoren bereit.

Außerdem gibt es umfangreiche Online-Schulungen, geführte Tutorials, Videos, Beispielprojekte, Stack Overflow und vieles mehr.

Große Community durch Open Source

Kafka ist eines der fünf aktivsten Projekte der Apache Software Foundation, mit Hunderten von Anwendern, Contributern & Events auf der ganzen Welt.

Von tausenden Organisationen als vertrauenswürdig eingestuft

E-Commerce Unternehmen, Hersteller und führende Plattformen setzen auf Apache Kafka als die Technologie der Zukunft des Datenmanagements.

Kafkas Fähigkeiten

Kafka kombiniert drei entscheidende Fähigkeiten, so dass Sie Ihre Anwendungsfälle für das Event-Streaming von Anfang bis Ende mit einer einzigen bewährten Lösung umsetzen können:

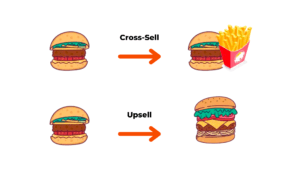

- Um Event-Streams zu erstellen (schreiben) und zu abonnieren (lesen), einschließlich des kontinuierlichen Imports/Exports Ihrer Daten aus verschiedenen Systemen.

- Um Event-Streams dauerhaft und zuverlässig zu speichern, solange du willst.

- Verarbeitung von Ereignisströmen bei ihrem Auftreten oder rückblickend.

All diese Fähigkeiten werden in einer verteilten, hoch skalierbaren, elastischen, fehlertoleranten und sicheren Architektur bereitgestellt.

Nutze die Macht von Echtzeit Datensynchronisation, um die nächste Generation des Handels zu schaffen. Biete ansprechende Omnichannel-Kundenerlebnisse, verbessere die Kundenbindung und schaffe datengetriebene Geschäftsprozesse.

Datensynchronisation über Kafka und Eventstreams für dein Unternehmen. Ohne Kopfschmerzen und ohne zusätzliche In-House Kapazität.

Wir stellen unseren Kunden zentralisierte, moderne Datenmanagementsysteme nach ihren individuellen Anforderungen bereit.

Dabei kümmern wir uns um das komplette Setup, den Betrieb der Cloud Infrastruktur, sowie der Wartung und Weiterentwicklung.

Vereinbare noch heute ein kostenloses Beratungsgespräch.